Всем привет.

Наконец-то, сбылась мечта идиота: запустить более 10 карт на одной ферме. Почему именно более 10? Потому-что в Windows не обнаруживается более 10 GPU (так говорят, сам не проверял). И вроде как только линукс может поддерживать более 10 графических ядер. Спортивный интерес, так сказать.

А началось всё с того, что у меня в планах временный переезд за границу, при этом все мои фермочки остаются на родине, за ними нужно как-то следить. Для решения данной задачи было решено перевести все фермы на серверный сокет, потому-что в серверных материнских платах есть Managment Port, который позволяет иметь полный доступ к управлению компьютером: можно в биос зайти, можно ресет нажать, можно выключить/включить, переустановить операционную систему и т.п. Таким образом, физическое присутствие возле ферм понадобится только при необходимости заменить какую-то деталь, всё остальное можно делать удалённо и не напрягать лишний раз кума/свата/брата. Т.к. все наслышаны о большом количестве линий PCI-E в серверных системах, потому попутно проснулся и спортивный интерес: воткнуть больше карт. Дайте мне таблеток от жадности, да побольше, побольше! :lol: Кроме того, я люблю вау эффект, готов переплачивать за плюшки и прочие удобства.

Начал искать в каталогах оптимальную материнку: максимум PCI-E слотов (не менее 6), сокет 2011/2011-3 (на 1366 искать не стал, устаревшие), наличие менеджмент порта (далеко не на всех платах он есть), наличие M.2 порта было бы плюсом. Процессоры под 2011-3 оказались черезчур дорогими, тогда как для 2011 на рынке полно б/у ксеонов E5-1620 (4 ядра/8 потоков, 3.6Мгц), всего по 40-50$, потому остановился на сокете 2011.

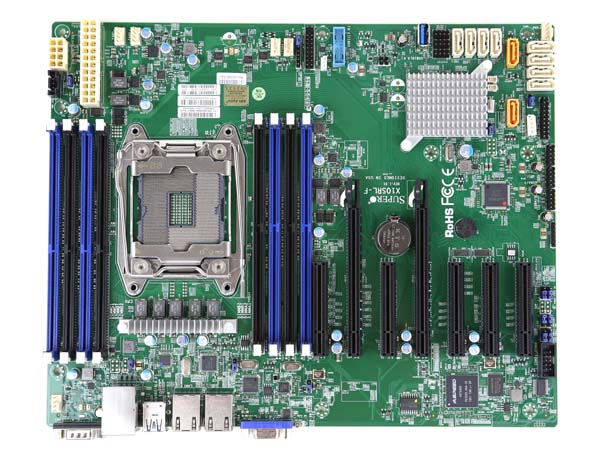

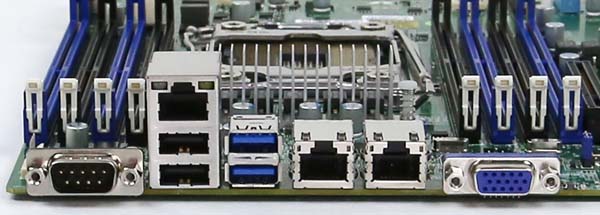

Из возможных к заказу подходящих МП мне подошла Supermicro X9SRL-F http://www.supermicro.com/products/motherboard/Xeon/C600/X9SRL-F.cfm

Обошлась она мне в 340$ за новую. У этой платы (или может производителя в целом) оказалась самая жлобская комплектация, которую я когда-либо видел :lol: В коробке с мамкой была заглушка на корпус и 6 SATAII кабелей. Т.е. ни одного SATAIII кабеля, ни одной косички, даже руководства пользователя не было :huh: Стоит также отметить, что в данной плате один из портов является PCH.

Фермы планировалось устанавливать в закрытые 4U корпуса, корпус купил здесь на форуме https://forum.bits.media/index.php?/topic/30284-ukrainakiev-gpu-korpusa-i-fermy-dlia-maininga-ethereum-i-zcash/, фото продавца:

Т.к. расчёт был на установку 8 карт в одной ферме, для этого не обойтись без мощного блока питания, потому-что имеющийся корпус не позволял установить в него 2 БП (без колхоза), и я вновь отправился на поиски по каталогам. Серверные БП не рассматриваю, это на уровне религии наверное :P Выбор пал на Super Flower Leadex Platinum 2000W, как самый мощный из доступных с одной линией 12В.

Стоит он правда, не мало: 450$. На текущих моих фермах стоит по два SeaSonic Platinum P-1200 (1200Вт), так-что один новый "пупсик" стоит дешевле, чем эти два, а его мощности с головой достаточно на 8 популярных на данный момент RX 480, ещё и на апгрейд карт есть немного запаса.

В качестве первой партии видеокарт заказал 8 Sapphire Nitro+ RX 480 8Gb.

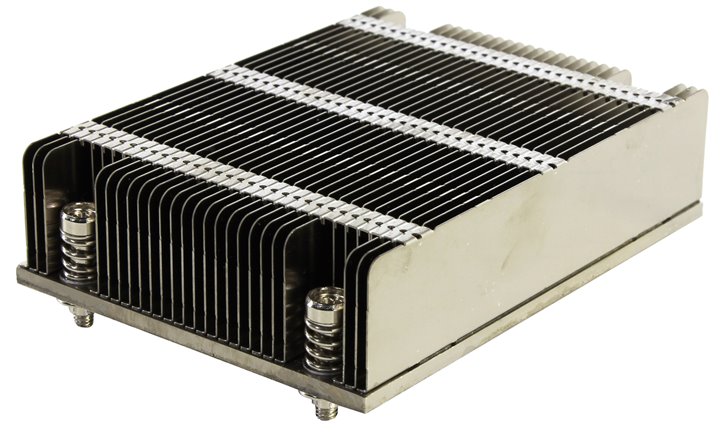

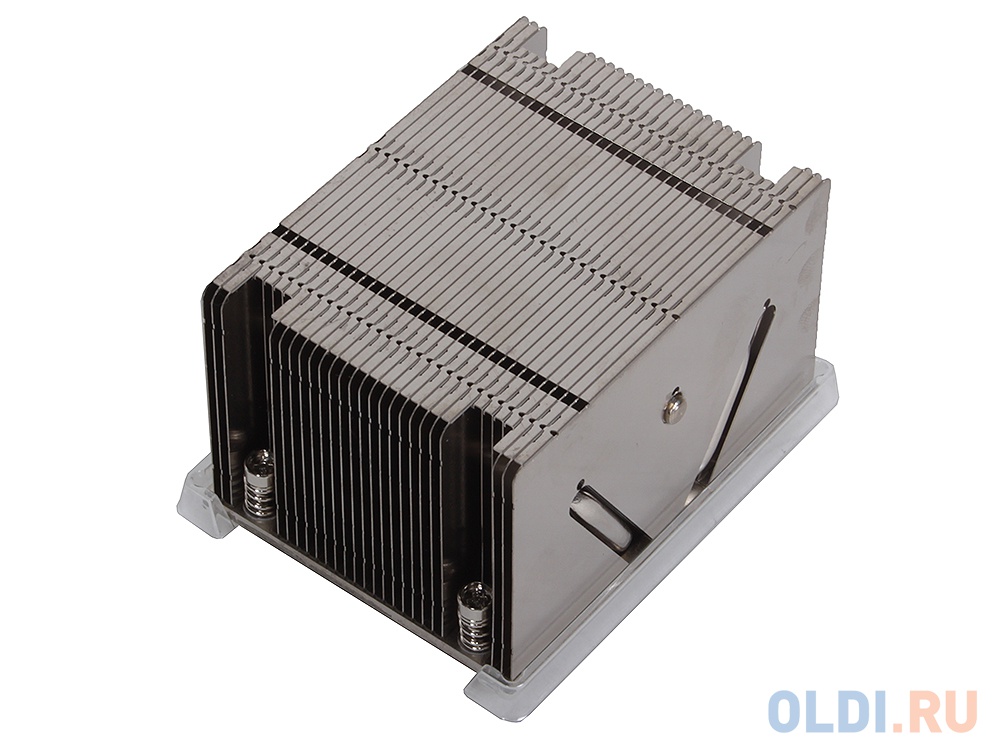

Отдельно хочу рассказать про историю с процессором, а точнее, с его охлаждением. Купленный б/у процессор был без кулера, потому я заказал самый дешёвый попавшийся на глаза кулер: Supermicro SNK-P0047P.

Учитывая нулевую нагрузку на процессор при майнинге, не стал я заказывать активный кулер (с вентилятором), т.к. в каталоге самый дешёвый вариант был в 4 раза дороже этого б/у.

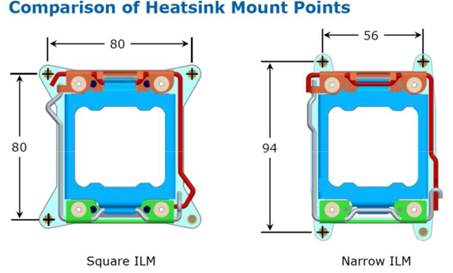

Т.к. с 2011 сокетом я дела никогда не имел, для меня стало неожиданностью, что в нём есть два типа крепления процессорного охлаждения: Square ILM и Narrow ILM.

И, как оказалось, купленный кулер не подходит на данную МП. Дело было в субботу, что-либо заказать и получить сегодня же не предоставлялось возможным, а я так ждал этих выходных :lol:

Ну, что же делать, полез искать другой кулер. Выбрал Scythe Katana 4 SCKTN-4000, как недорогой и небольшой, кулер универсальный, с поддержкой многих сокетов, в том числе и 2011.

Ну что, приехал этот кулер во вторник, и я бегом побежал примерять его к мамке. И что вы думаете? Снова из меня сыпется куча мата, ибо это гавно имело переходник только на квадратное крепление :lol: Ради интереса полез на сайт производителя, там написано "кулер поддерживает сокет 2011", и на этом всё, о типе крепления ни слова. Как оказалось позже, просматривая другие кулеры, почти во всех каталогах и сайтах производителей не указан тип крепления, при этом загуглив конкретную модель, находились отзывы, что кулер поддерживает только квадратное крепление. Мой нос снова свесился, ибо я не мог в каталоге найти нужный кулер, потому-что приходилось гуглить каждую модель в поисках информации о поддержке типа крепления, а на это уходило много драгоценного времени.

Позже вспомнив, что с первым пассивным куллером попадался на глаза и другой пассивный, немного крупнее, решил посмотреть его. И о чудо, он имел именно нужное мне крепление :lol: Им оказался Supermicro SNK-P0048PS, который стоил в два раза дороже первого, но в первый раз я зажлобил на него, ибо если нет разницы, зачем платить больше? :D

Не долго думая, собираю всех купленных "лузеров" и еду с ними к продавцам в столицу (70км), на возврат. Продавец нужного кулера уверил, что без сильной продувки проц будет перегреваться, потому из 3х корпусных вентиляторов средний я развернул в сторону процессора.

Собрал я всё это дело в кучу. Память 2х 4Гб, винт SSD 120Gb. Почему 120Гб? Чтобы поселить на нём несколько операционных систем, и работать в той, где выгоднее на текущий момент. Установил Ubuntu 16.04, последний на тот момент драйвер amdgpu-pro 16.50 и optiminer для майнинга Zcash.

3 карты завелись без проблем, при подключении 4й получил звуковую алярму и переход в биос, где был устрашающий варнинг:

PCI OUT OF RESOURCES CONDITION:

Error: Insufficient PCI Resources Detected!!!

System is running with Insufficient PCI Resources!

In order to display this message some

PCI devices were set to disabled state!

It is strongly recommended to Power Off the system and remove some PCI/PCI Express cards from the system!

To continue booting, proceed to Menu Option and select Boot Device or .

WARNING: If you choose to continue booting some Operating

Systems might not be able to complete boot correctly!

Т.е. плата нам сообщает, что PCI ресурсы заканчиваются, выдерните что-нибудь лишнее. Но там же был и такая инфа:

Please change your BIOS settings:

BIOS > Advanced > PCIe/PCI/PnP Configuration > Above 4G Decoding and set it to Enabled.

Не долго думая, лезу туда и правлю указанный конфиг. Попутно отключаю всё лишнее/ненужное. Теперь всё заводится, система грузится, майнинг на 4х картах работает.

При работе в биосе меня ждал серьёзный нежданчик: проц очень сильно грелся, иногда доходило до звуковых алертов перегрева, после чего приходилось быстро сохранять биос и тушить систему на некоторое время. Вентилятор не справлялся, как позже оказалось, из-за моей рукожопости: я его воткнул (голые провода) в 5В, вместо 12В. При этом, при майнинге на таких оборотах вентилятора радиатор процессора со временем становился и вовсе холодным, т.е. активный кулер оказался нужным только для биоса :unsure:

При добавлении 5й карты хешрейт у всех карт изменился до 50-60 сол/с, тогда как обычно у карт RX 480 хешрейт на уровне 200-220 сол/с. Полез в биос, там есть возможность указать режим совместимости каждого PCI-E слота: Gen1/Gen2/Gen3. По умолчанию у 6 слотов установлено Gen3, седьмым слотом управлять нельзя, т.к. это PCH слот, но видеокарта в нём успешно работает. В общем, при Gen1 хешрейт не изменился, при Gen2 всё заработало как планировалось.

Добавляю карты, заполняю все 7 слотов, всё работает. Ставлю плату расширения 1-3 PCI-E в слот х16, переставляю в него некоторые карты. Включаю - всё работает. Добавляю последнюю, 8ю карту, полёт нормальный. Всё, можно доставать шампанское! А нет, как же спортивный интерес? :lol:

Разбираю соседнюю ферму с R9 390, добавляю по одной. Добавляю вторую плату расширения во второй х16 слот - не работает. При чём не работает именно расширитель в дальнем от проца слоте. Переставляю из х16 в ближайший к процессору х1, оба работают. Добавляю ещё карт по одной. С какого-то момента карта во втором слоте стала выдавать всего 50-60 сол/с, потому переставил её оттуда в расширитель.

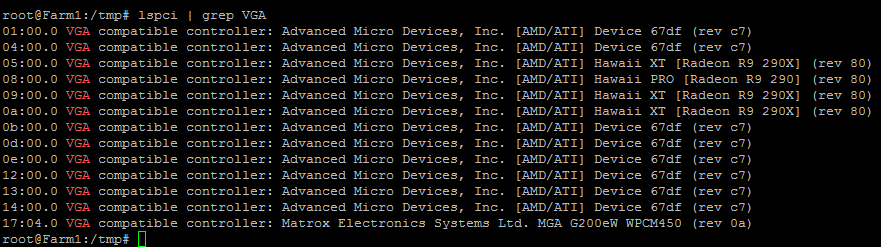

Пора добавлять третий расширитель, думаю куда его воткнуть, учитывая что в двух х16 слотах работает только один из них (отдельно один расширитель работает в обоих слотах). Не долго думая, решаю подключить третий каскадно, т.е. воткнуть его в расширитель. Тоже никаких особенностей, всё завелось и работало как нужно. Таким образом, нарастил количество карт до 12 штук: 8 RX 480 и 4 R9 390.

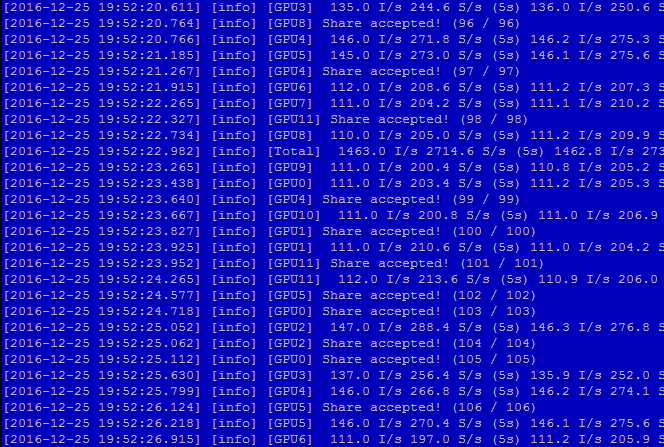

В майнере "правильный" хешрейт:

Потом ради интереса воткнул коммутатор в PCH слот, там тоже всё работало как положено.

Всё это собиралось "на коленке", в ограниченном пространстве, особенно учитывая изначальное расположение фермы в 4U корпусе. Получилось вот такое чудо-юдо :lol:

У меня были ещё карты, ещё расширители, но как подумал куда всё это дело пристроить в таком хаосе, решил, что этого пока достаточно для первого эксперимента. Разгоны не проводил, все карты в стоке.

Ещё перед сборкой этого зоопарка я мечтал, что смогу запустить на такой системе более 8 карт, и для размещения такой фермы заказал себе корпус Thermaltake Core X9 http://www.overclockers.ua/case/thermaltake-core-x9/all/

Скажу честно, когда это чудо приехало, я был шокирован его размерами, ожидал увидеть гробик меньше раза в два. Но теперь я точно уверен, что в него и 20 карт влезет :lol: Так-что, наверняка следующая моя запись в блоге будет "Установка фермы с 12+ карт в корпус Thermaltake Core X9" :rolleyes: ну и, раз влезет 20 карт, значит пора собирать двухпроцессорное решение :D Скажу сразу, попадались нужные материнские платы в примерно той же ценовой категории, в пределах 350$, а второй процессор, как я уже писал, можно купить за 40-50$ + 40$ на комплект памяти для него, итого получаем не сильное удорожание для ещё ХХ карт.

PS. Эксперимент окончен, ферма из 12 карт разобрана, сейчас на ней трудятся купленные 8 карт RX 480, так-что что-либо проверить по желанию комментаторов не смогу.

Upd. 10.01.2017

Пришла вторая партия карт, свободных слотов с переходниками хватило только на 15 карт. При подключенных 15 картах майнинг Zcash работал только на 13, как оптимайнер, так и клеймор. Причина не ясна, т.к. в списке устройств отображаются все карты. Другие майнеры и монеты не проверял. Собственно, сейчас на ферме трудятся 13 карт RX 480 8G.

[Total] 1943.0 I/s 3627.8 S/s (5s) 1948.7 I/s 3661.1 S/s (1m) 1949.7 I/s 3663.0 S/s (1h)

Upd. 07.02.2017

На данный момент в риге работает 10 карт, продолжать эксперименты пока-что нет возможности. Думаю, через месяц-два вернусь к этим вопросам.

100 Комментариев

Рекомендуемые комментарии

Для публикации сообщений создайте учётную запись или авторизуйтесь

Вы должны быть пользователем, чтобы оставить комментарий

Создать учетную запись

Зарегистрируйте новую учётную запись в нашем сообществе. Это очень просто!

Регистрация нового пользователяВойти

Уже есть аккаунт? Войти в систему.

Войти